Mellerikat LLMOps

LLMOps는 개발자가 신경 쓸 필요 없이 클라이드 환경에서 서비스를 손쉽게 배포하고 운영할 수 있게 도와주는 도구 입니다. 대규모 언어 모델(LLM) 기반 서비스를 배포하기 위한 복잡하고 다양한 일련의 과정들을 자동화하여 개발자는 AI Agent 서비스를 손쉽게 배포-운영-고도화 할 수 있습니다.

아래의 플레이어를 통해 mellerikat LLMOps에 대한 자세한 내용을 팟캐스트로 들어보세요.

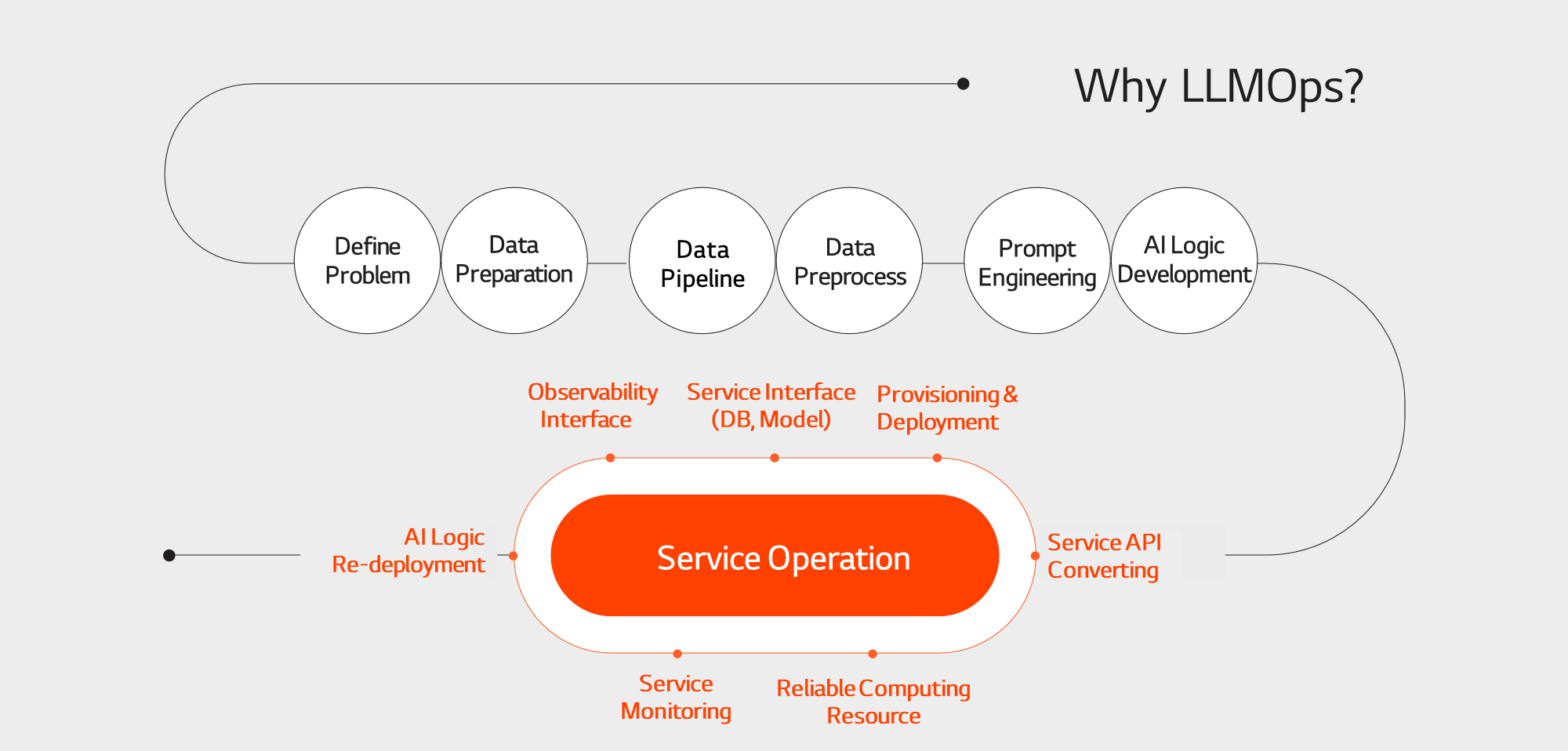

Why LLMOps?

지속 가능한 LLM 서비스 운영이 어려운 이유

단순히 로컬에서 LLM 서비스를 동작하게 만들어 보는 것과 달리, LLM 기반 서비스를 운영하는 작업은 복잡한 과정이 요구됩니다.

예를 들어, 컨테이너화 작업, 데이터베이스 및 서비스 연동, 모니터링 시스템 설정, 네트워크 및 보안 설정, 그리고 배포 스크립트 작성 등이 필요합니다.

이런 과정을 반복적으로 수행하다 보면 시간과 노력이 많이 들고, 조직 전체적으로 낭비가 생기게 됩니다.

LLMOps는 LLM 기반의 서비스 개발 및 운영 과정에서 발생하는 다양한 기술적 과제를 해결하고,개발자들이 더 창의적이고 생산적인 작업에 집중할 수 있도록 지원하는 솔루션 입니다.

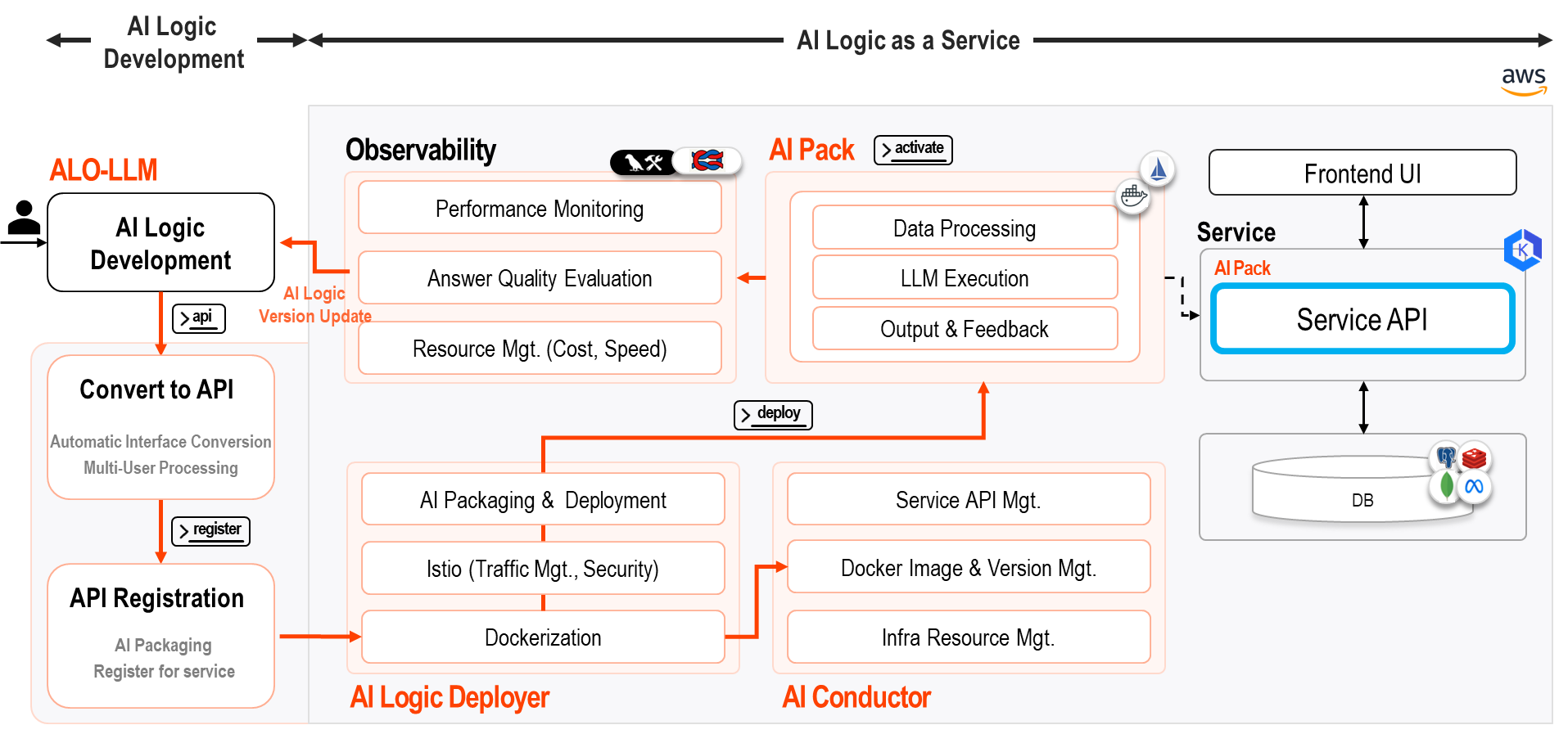

Service Architecture

고품질의 LLM 서비스를 손쉽게 개발하고 지속 운영 가능한 LLMOps

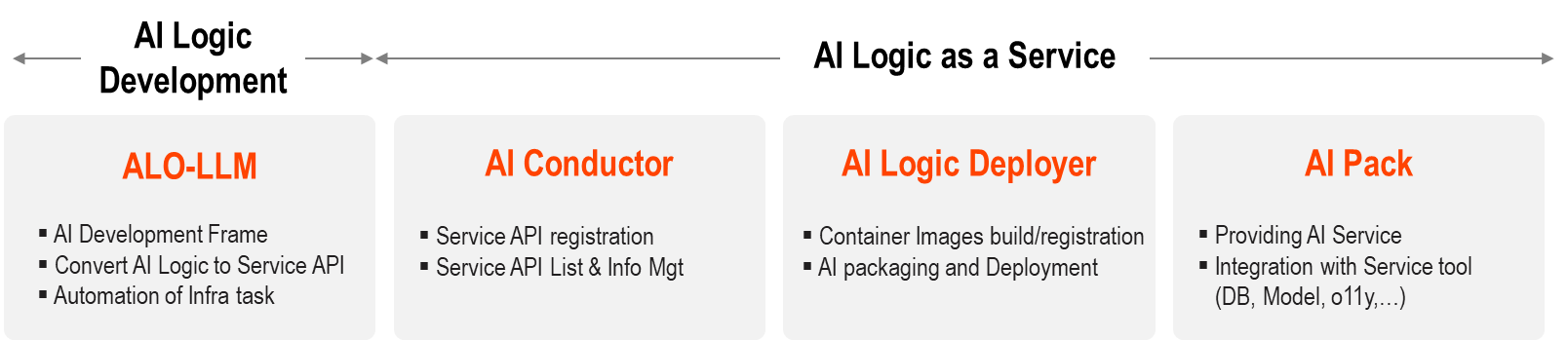

mellerikat LLMOps은 네 가지 핵심 요소로 구성된 솔루션입니다 : AI Learning Organizer(이하 ALO), AI Coductor, AI Logic Deployer, AI Pack

이 솔루션은 복잡한 API 개발 과정과 지속적인 운영의 어려움을 쉽게 해결하도록 각 과정에서 필요한 기능들을 제공�하여 사용자가 보다 편리하게 작업할 수 있도록 지원합니다.

그리고 LLM 서비스 과정에서 수집된 피드백을 수집하여 서비스를 지속 고도화할 수 있도록 Oberservalility 도구와의 연동도 지원합니다.

AI Logic 개발

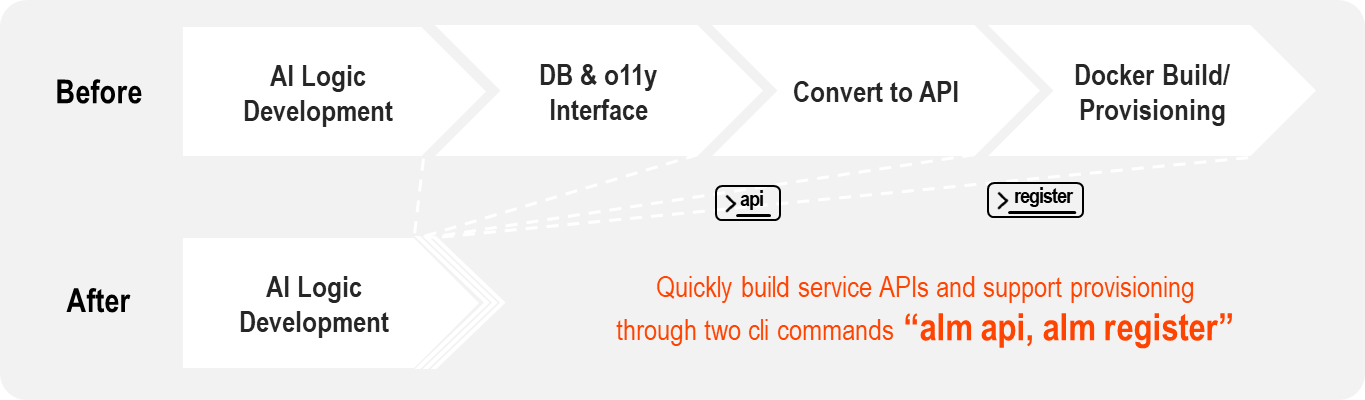

쉽고 간편하게 만드는 표준화된 LLM 개발도구, ALO-LLM

표준화된 개발도구인 ALO-LLM은 개발자들이 쉽게 고품질의 LLM 서비스를 개발할 수 있도록 도와줍니다.

이 도구는 일관된 코딩 규격과 서식을 제공하여 코드 품질을 유지하고, 서비스 유지보수를 간편하게 만들어 줍니다.

또한, 서비스 API 변환을 자동으로 지원하는 기능이 있어 개발 과정이 훨씬 더 효율적이고 빠르게 진행될 수 있습니다.

AI 서비스 운영

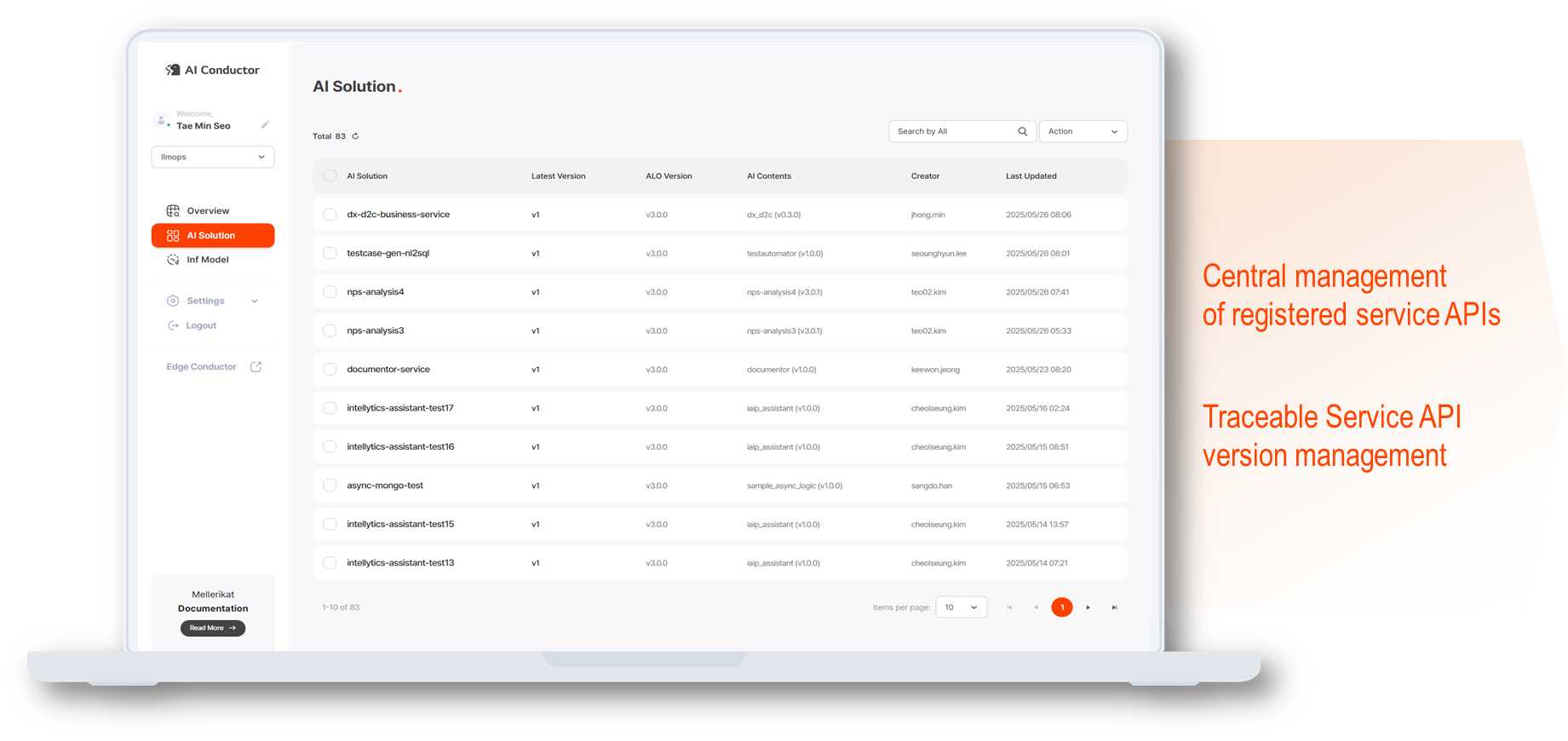

등록된 Service API를 종합 모니터링 할 수 있는 AI Conductor

ALO로 개발된 서비스 API를 AI Conductor에 등록하고, 사용자는 AI Conductor를 통해 운영 중인 서비스 API들을 버전별로 관리할 수 있습니다.

AI Conductor는 서비스 API 운영에 필요한 메타정보를 등록하고 종합 모니터링할 수 있는 웹 기반 UI를 제공하여 지속적인 LLMOps 운영을 지원합니다.

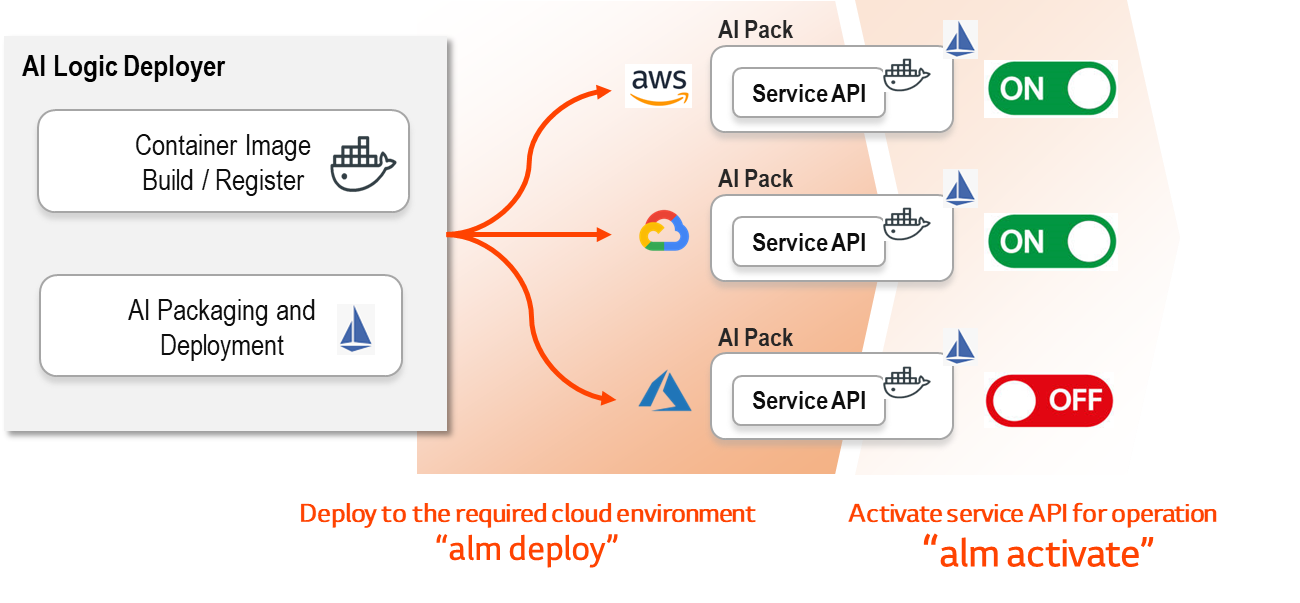

AI Logic Deployer로 다양한 클라우드 환경으로 간편하게 서비스 API 배포

다양한 클라우드 환경에 서비스 API를 손쉽게 배포할 수 있습니다.

복잡한 설정이나 절차 없이, 자동화된 배포 시스템 설치를 통해 원하는 클라우드 환경에 서비스 API를 간편하게 배포하고 운영할 수 있습니다.

이로 인해, 복잡한 기술적인 운영 과정이 크게 줄어들고, 서비스를 빠르게 시작할 수 있어 개발자에게 더 나은 경험을 제공합니다.

또한, 운영 과정이 간단해짐에 따라 더 이상 복잡한 서버 관리나 배포 작업에 많은 시간을 할애할 필요가 없어 전체적인 운영 효율성이 크게 향상됩니다.

명령어 만으로 간단하게 Service API 운영, AI Logic Deployer

서비스 API를 운영하기 위해서는 애플리케이션을 docker화 하고, 서비스 메쉬인 istio를 적용하는 과정에서 많은 노하우와 시간이 필요합니다.

또한 애플리케이션을 Kubernetes의 Pod에 배포하고 트래픽을 관리하는 것도 쉽지 않은 일이었습니다.

AI Logic Deployer는 이를 간단한 CLI 명령어로 해결할 수 있게 해 줍니다.

복잡한 과정을 자동화하여 애플리케이션을 컨테이너화하고, istio를 통해 트래픽 관리 및 보안 기능을 손쉽게 추가할 수 있습니다.

AI Logic Deployer를 통해 더 이상 복잡한 기술적인 운영 과정에 많은 시간을 할애할 필요 없이, 손쉽게 서비스 API를 배포하고 운영할 수 있습니다.

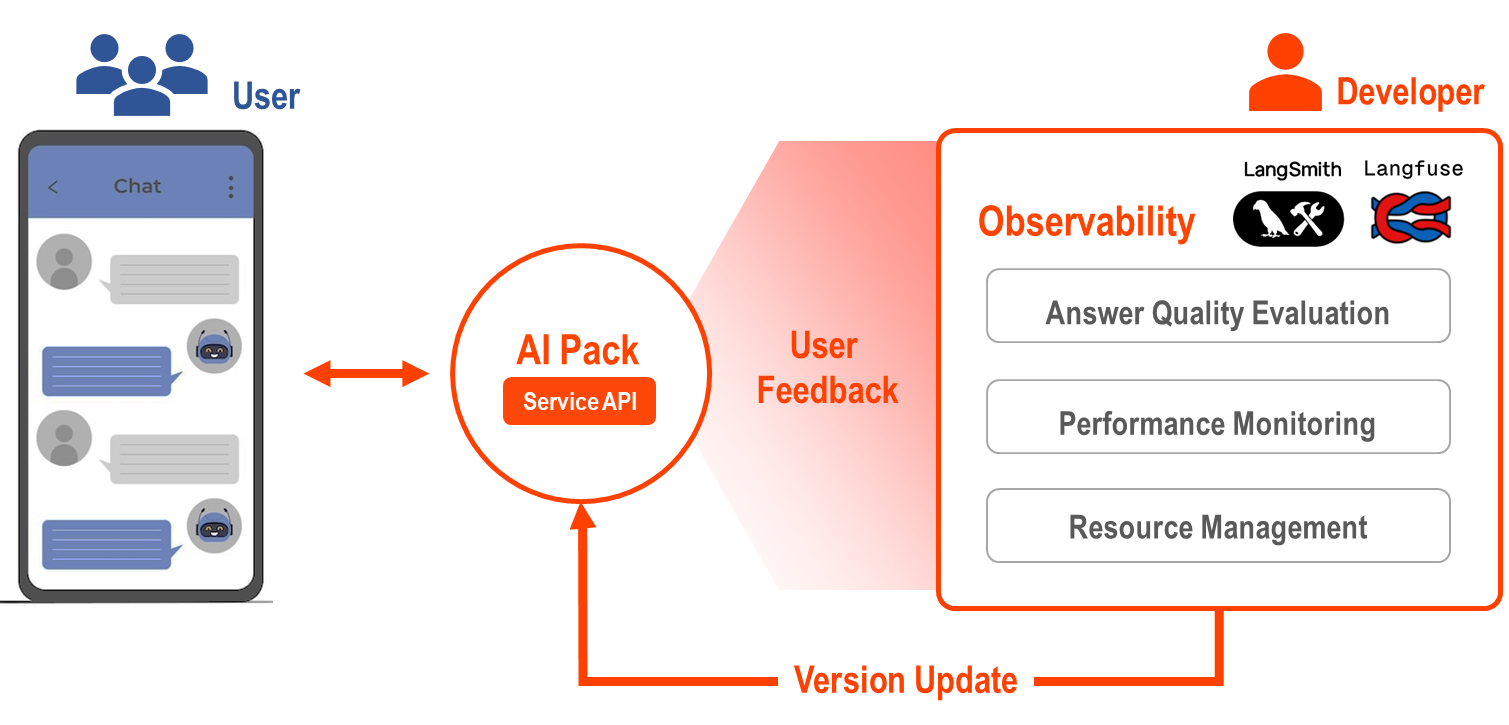

AI Pack으로 패키징 하여 다양한 서비스 도구들과의 원활한 연동

AI Pack은 여러 서비스 도구들과의 연동을 통해, 다양한 기능을 결합하여 효율적이고 유연한 운영 환경을 지원합니다.

AI Pack은 LLM 서비스 운영에 필요로 하는 데이터가 담긴 Database와 서비스 성능 개선을 위한 Oberservalility 도구와의 연계를 통해

데이터 추출/분석, 사용자 피드백 수집 모니터링 등을 활용할 수 있어 운영의 효율성을 극대화합니다.

AI Pack과 함께라면, 복잡한 운영 환경을 단순화하고, 보다 스마트한 운영 전략을 구현할 수 있습니다.

AI Pack과 Observability로 간편하게 사용자 답변 품질 관리 및 로직 최적화

AI Pack은 단순한 AI 실행 도구를 넘어, 답변 품질, 처리 속도, 비용 등을 실시간으로 모니터링하고 분석할 수 있는 observability 모듈과 연동됩니다.

이를 통해 개발자는 AI가 제공하는 답변의 품질을 지속적으로 평가하고, 성능을 개선할 수 있습니다.

또한, AI가 처리하는 속도나 리소스 사용량에 따른 비용도 투명하게 확인할 수 있어, 효율적인 운영이 가능합니다.

Mellerikat LLMOps

"AI 운영의 새로운 패러다임, Mellerikat LLMOps로 시작하세요!"

지속 가능한 LLM 서비스 운영의 어려움을 Mellerikat LLMOps가 해결해드립니다.

복잡한 배포와 운영 과정을 자동화하고, 개발자의 시간과 노력을 절약하여 창의적인 작업에 집중할 수 있도록 지원합니다.

이제 LLMOps와 함께라면, 클라우드 환경에서 손쉽게 API를 배포하고, 효율적인 운영을 통해 사용자에게 더 나은 경험을 제공할 수 있습니다.

"LLM 기반 서비스의 미래를 함께 만들어가세요!"