AI Logic Deployer

AI Logic Deployer는 LLM 서비스의 배포와 운영을 혁신적으로 단순화하는 도구입�니다.

다양한 인프라 환경을 지원하며, CLI 기반의 직관적인 명령어만으로 Service API 패키징, 등록 배포, 활성화까지 모든 과정을 자동화합니다.

개발자는 복잡한 운영 부담 없이 빠르게 서비스를 출시하고, 안정적으로 관리할 수 있어 서비스 개발과 개선에 더 집중할 수 있습니다.

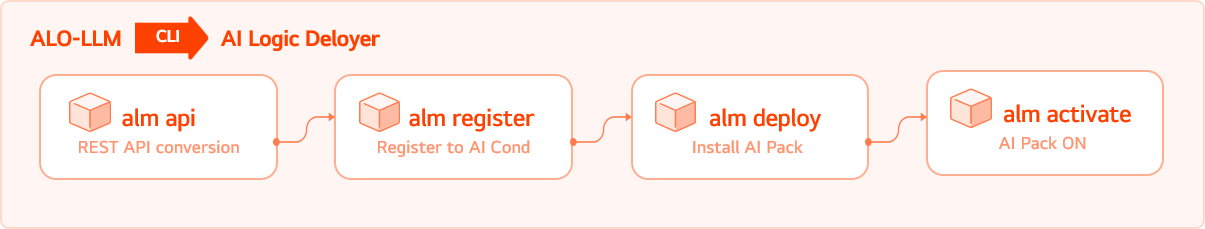

Simplified Workflow

복잡한 운영 과정을 단순화하는 자동화된 배포 환경

AI Logic Deployer는 복잡한 API 개발과 운영 환경의 부담을 줄이기 위해 설계되었습니다.

서비스를 Docker 이미지로 패키징하고, Istio 기반의 서비스 메쉬를 구성하며, Kubernetes Pod에 배포하여 트래픽을 관리하는 전 과정을 CLI 명령어 한 줄로 자동화할 수 있습니다.

이러한 자동화된 워크플로우를 통해 개발자는 인프라 구성이나 배포 전략에 대한 부담 없이, 보다 빠르고 안정적으로 서비스 API를 운영할 수 있습니다.

기술적인 운영 과정에 소요되는 시간을 최소화하고, 개발과 서비스 개선에 더 많은 역량을 집중할 수 있도록 돕습니다.

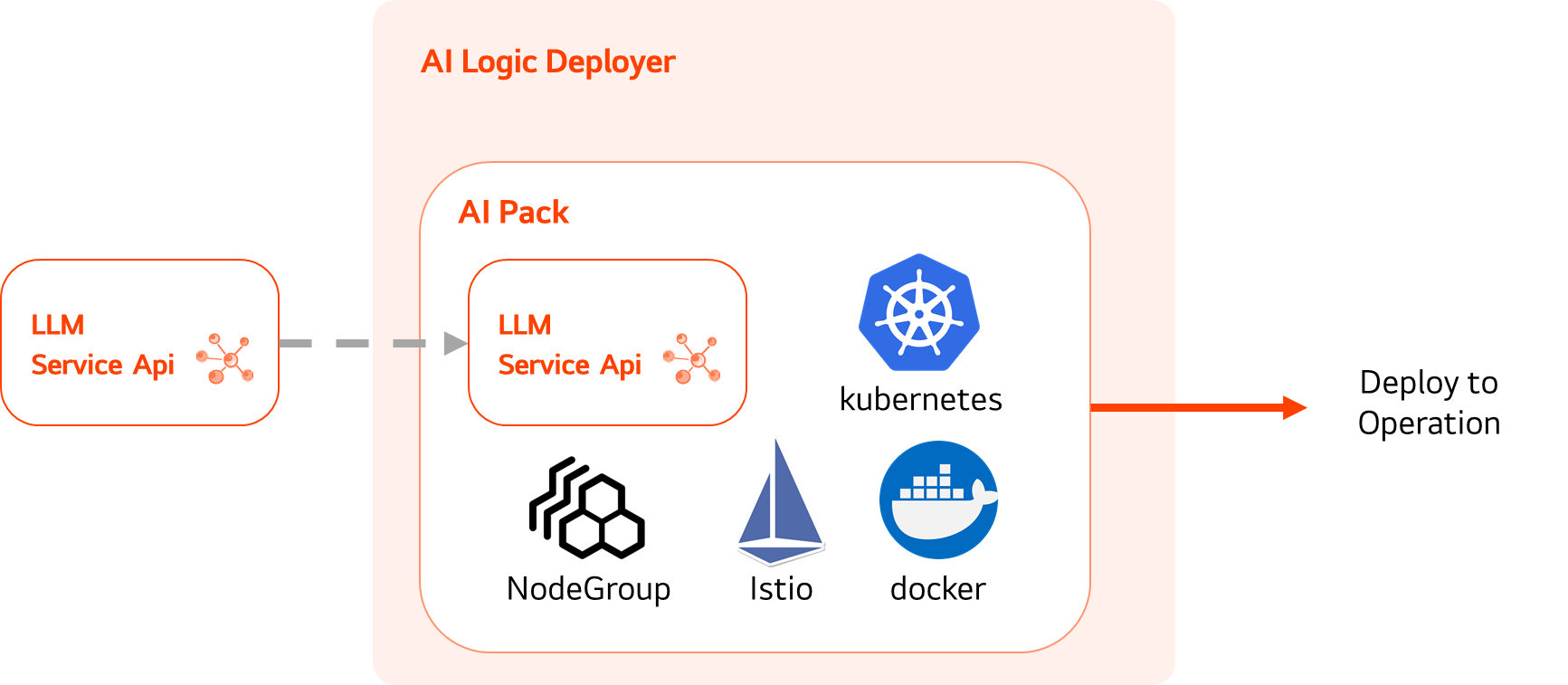

AI Pack

LLM 서비스 운영을 위한 최적화된 환경 제공

AI Logic Deployer의 핵심 구성 요소 중 하나인 AI Pack은 Service API의 안정적인 배포와 운영을 위한 최적화된 인프라 환경을 제공합니다.

AI Logic Deployer는 Service API가 컨테이너화된 도커(Docker) 환경에서 실행되기 전에, AI Pack을 자동으로 설치하여 필요한 인프라 기반을 구축합니다.

이는 단순히 서비스를 배포하는 것을 넘어, LLM Service Logic이 원활하게 동작하고 API 인터페이스를 통해 프론트엔드, 데이터베이스(DB),

그리고 옵저버빌리티(Observability) 도구들과 유기적으로 연동될 수 있는 완벽한 운영 환경을 제공함을 의미합니다.

독립적인 서비스 운영 환경 제공

AI Pack을 통해 자동으로 구축되는 인프라 환경은 다른 LLM 서비스에 영향을 미치지 않도록 독립적으로 구성됩니다.

예를 들어, 특정 서비스에 사용자가 과도하게 몰려 메모리 부족으로 서비스가 일시적으로 중단되더라도,

해당 서비스만 영향을 받고 다른 LLM 서비스들은 안정적으로 운영될 수 있어 전체 시스템의 안정성이 보장됩니다.

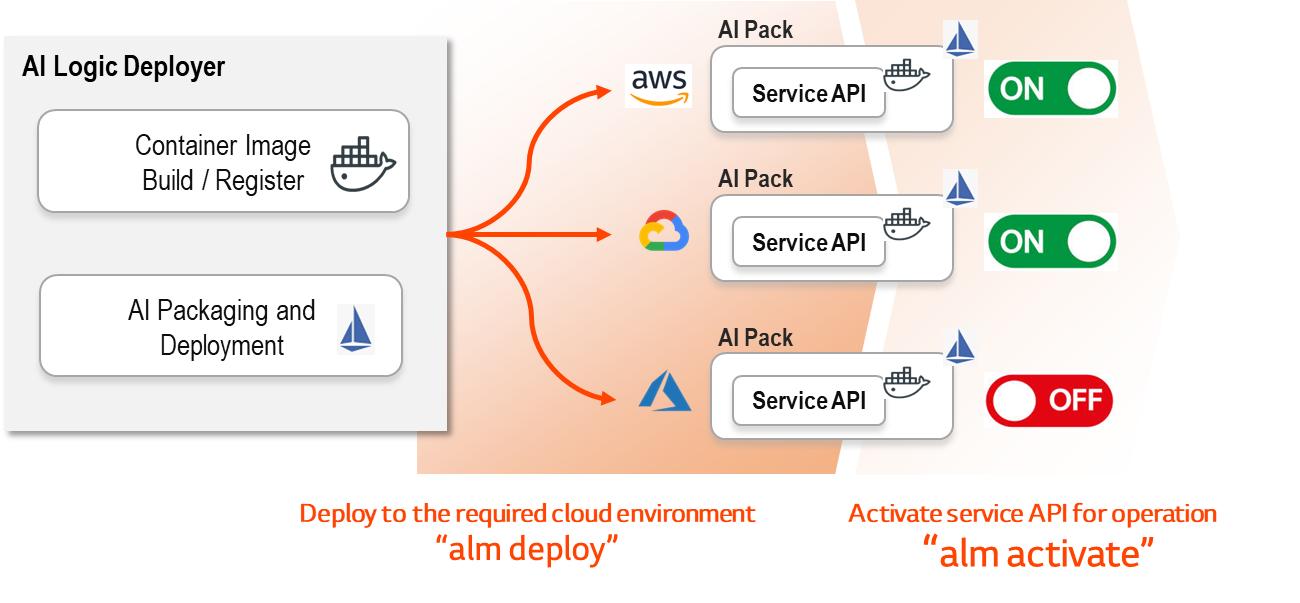

Multi-Cloud Compatibility

다양한 클라우드 운영 환경 지원

GCP, Azure, AWS 등 주요 클라우드 플랫폼에 대한 높은 호환성을 바탕으로, 다양한 운영 환경에서도 유연하게 구성할 수 있도록 설계되었습니다.

Helm 기반의 설치 방식을 채택하여 복잡한 설정 없이 빠르고 간편하게 시스템을 구축할 수 있습니다.

이러한 유연성과 간편함은 아키텍처 설계의 자유도를 높이고, 기술 운영 부담을 줄여 개발자에게 보다 효율적인 서비스 개발 및 운영 경험을 제공�합니다.

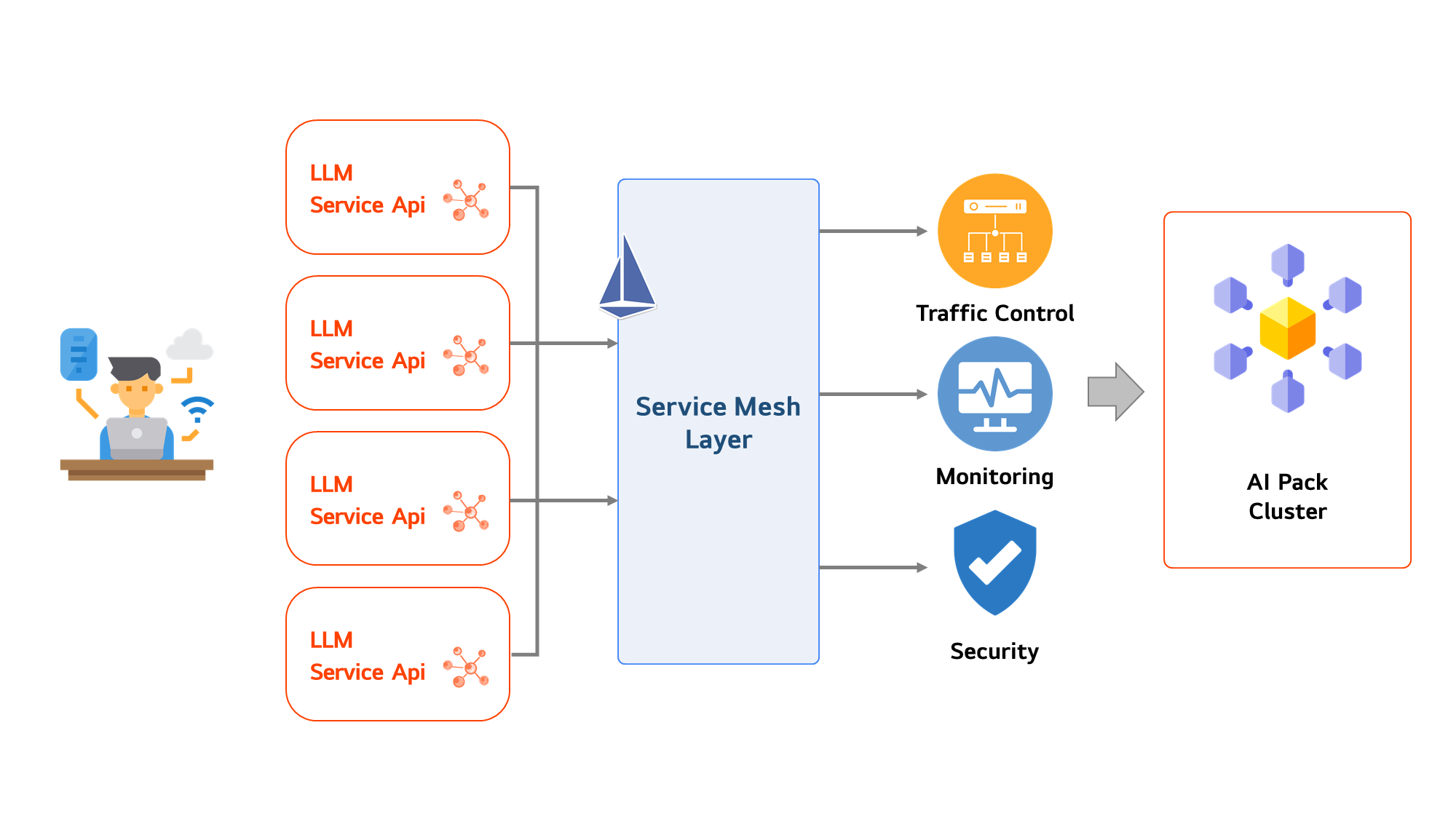

Micro-Service

Service Mesh 기반의 안정적인 마이크로서비스 지원

Service Mesh 기반의 설계를 바탕으로, 서비스 운영 환경에서 동작하는 AI Pack들 간 통신을 인프라 계층에서 중앙 관리함으로써 운영 효율성과 보안성을 높였습니다.

이를 통해 트래픽 제어, 실시간 모니터링, 장애 대응이 용이해지며, 더욱 안정적이고 신뢰할 수 있는 LLMOps 서비스를 제공합니다.

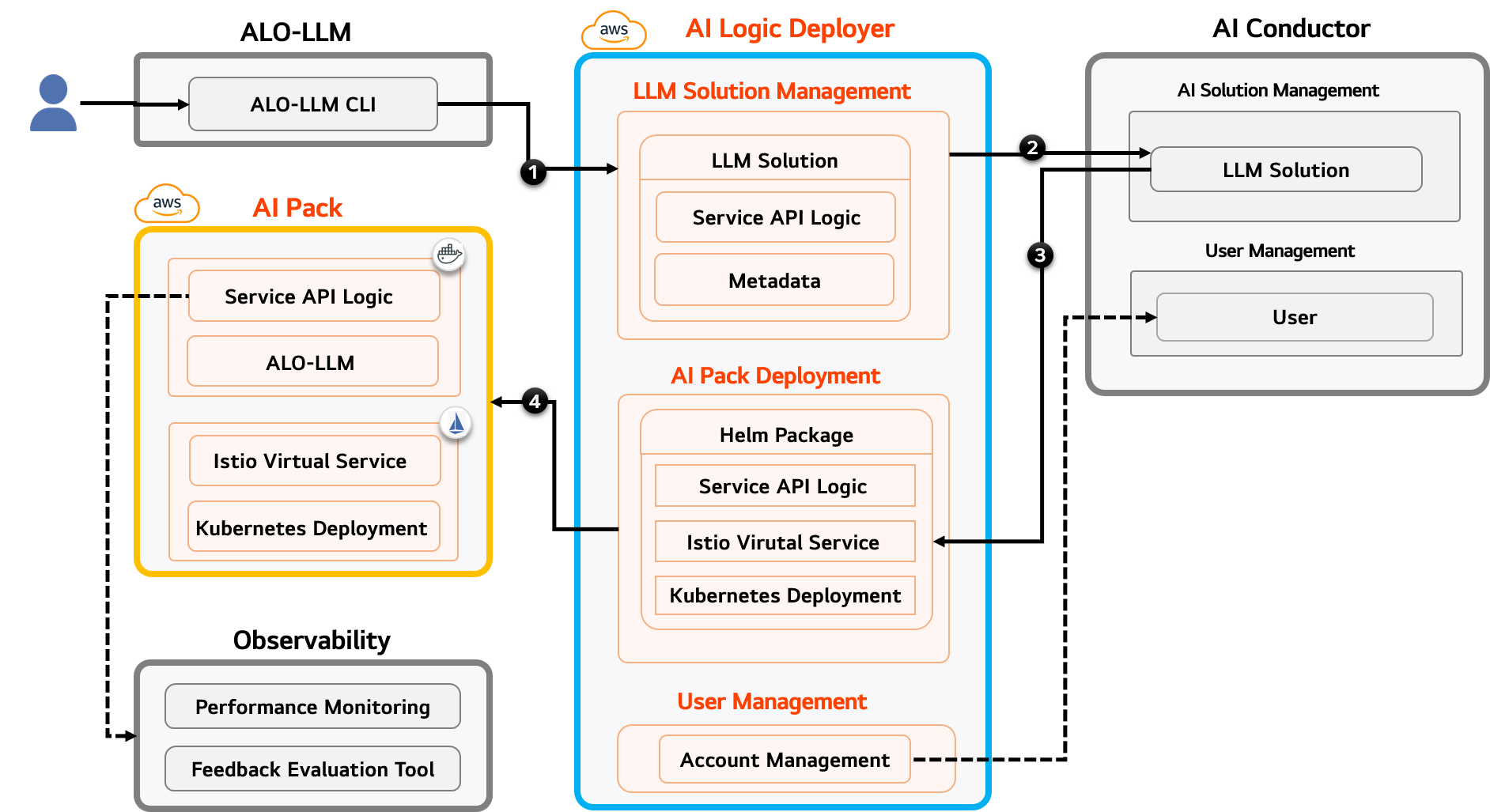

Architecture

간편한 운영을 위한 시스템 구조

개발자는 ALO-LLM CLI를 사용하여 LLM 서비스를 위한 Service API를 AI Conductor에 등록합니다.

등록 시에는 AI Conductor에서 제공하는 사용자 관리 기능을 활용하여 사용자 인증 절차를 진행합니다.

Service API는 AI Logic Deployer에서 Helm 패키지화 되어 쿠버네티스 플랫폼의 Istio Service Mesh에서 AI Pack으로 실행됩니다.

AI Pack에서 서비스 되어지는 Service API는 연동된 Observability를 통해 모니터링 됩니다.