LLM Observability의 메타지능화

LLM 서비스를 제대로 구현하기 위해서는 LLMOps 체계가 필수적입니다. 그 중에서도 observability(o11y) 는 단순 모니터링을 넘어 시스템의 ‘메타지능’ 을 가능하게 하는 핵심 요소로 발전하고 있습니다.

o11y가 ‘메타지능’으로 진화하는 과정

초기 LLM o11y는 토큰 사용량, 응답 시간, 응답 내용, 사용자 피드백 등을 수집해 성능을 모니터링하는 수준에 머물렀습니다. 저희는 Langsmith라는 상용 툴을 도입해 AI 로직의 실행 과정을 모니터링했으며, 이후 Langfuse라는 오픈소스 툴을 함께 통합하여 조직 내부에서 라이선스 유무에 따라 두 제품을 선택적으로 사용할 수 있게 했습니다.

그러나 AI Agent 서비스 이용자가 늘어나면서 쌓이는 데이터가 단순 로그 분석만으로는 의미 있는 통찰을 제공할 수 없다는 사실이 드러났습니다. 이에 우리는 o11y 데이터를 단순한 '관찰 기록'이 아닌 다음 단계로 이끄는 ‘메타지능 도구’ 로 진화시키기로 결정했습니다. 이 시스템은 AI Agent의 리턴값과 사용자 피드백을 바탕으로, 자동��으로 질문을 재구성하거나 답변의 품질을 향상시키는 방향으로 모델 행동을 조정할 수 있습니다.

즉, o11y 데이터는 실시간 성능 모니터링을 넘어서, AI Agent 스스로 개선하는 피드백 루프의 핵심 자료가 됩니다.

학술적으로도 이러한 접근은 AgentOps, 또는 Agentic AI 관측 시스템의 핵심으로 주목받고 있습니다. LLM 에이전트의 실행 경로, 내부 로직, 도구 호출, 계획 단계 등 다양한 아티팩트를 추적하는 AgentOps의 전체 관측 프레임워크를 제안하는 움직임도 있고, 블랙박스 평가를 넘어, 에이전트 실행 로그를 기반으로 행위 패턴을 추론하고 최적화하는 새로운 분석 루프의 중요성이 강조되기도 합니다.

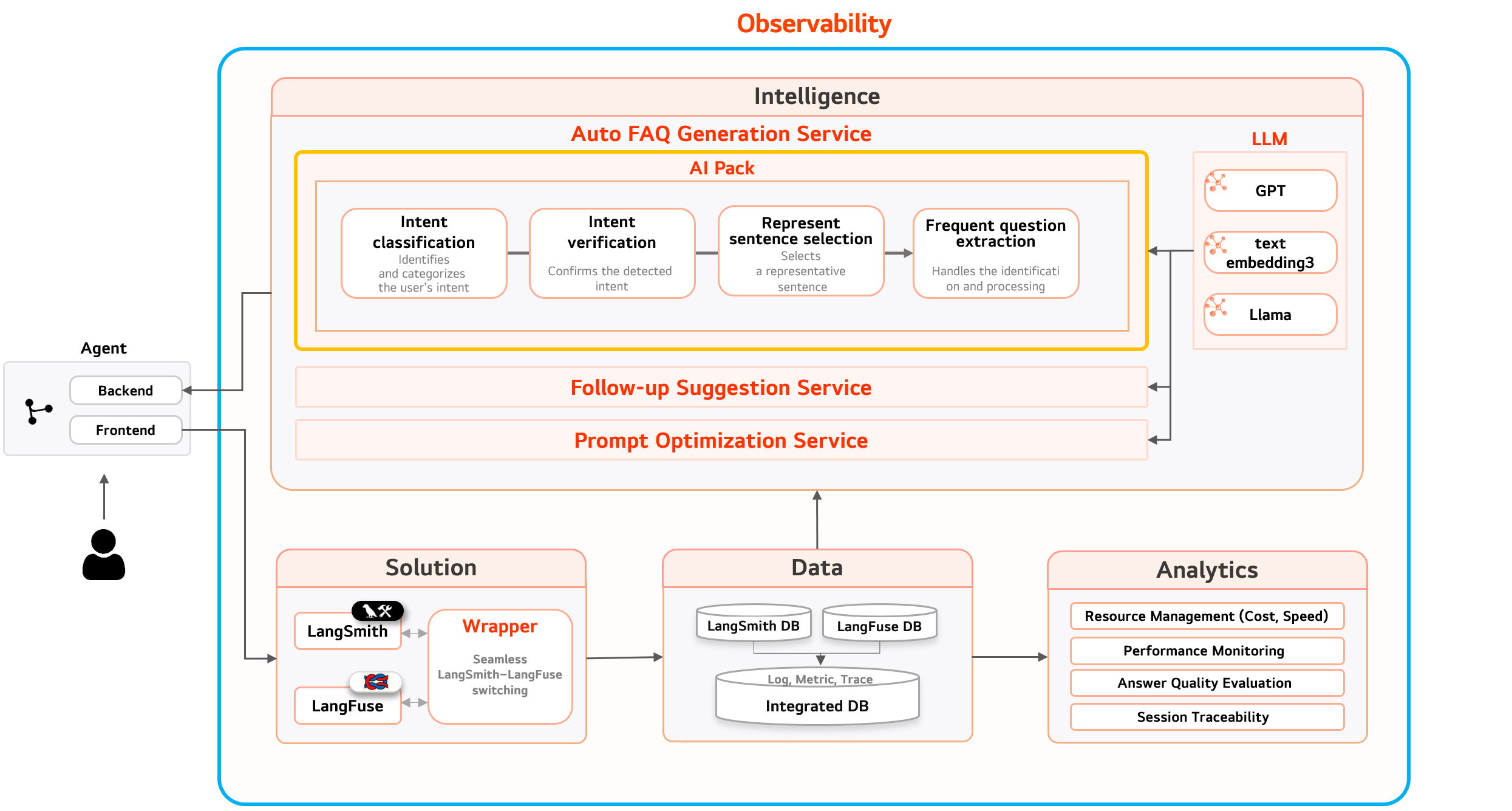

Mellerikat ‘메타지능 o11y’ 모델 구조

우리가 생각하고 만들어가는 o11y 메타지능화 전략은 다음과 같은 흐름으로 구성되어 있습니다.

-

Trace 기반 실행 기록 Langsmith와 Langfuse를 통해 LLM 호출, 내부 계획, 토큰 사용량, 응답, 피드백 등을 trace session 단위로 캡처합니다.

-

실시간 이상 탐지 및 피드백 루프 지연 시간이나 Hallucination 같은 오류가 감지되면 즉각적으로 알림과 자동 리포트가 생성되며, 사용자 피드백에 따라 자동 태깅 체계가 작동합니다.

-

메타 레이어 추론 엔진 수집된 데이터를 바탕으로 "어떤 질문이 더 적절한가?" 혹은 "답변을 어떻게 재구성해야 더 효과적인가?"와 같은 지능적 제안이 이루어집니다.

-

프롬프트 자동 조정 및 배포 메타지능 엔진이 프롬프트를 자동 수정하고, 변경된 로직은 CI/CD 파이프라인을 통해 실시간 적용됩니다.

이 구조는 기존 LLM 로직을 사용자가 직접 튜닝하는 것에서 나아가, 시스템 스스로가 지속적으로 개선 방향을 제시하고 실행하는 메타지능을 목표로 합니다.

오늘날 LLM 기반 AI 에이전트는 단순한 ‘응답 생성기’ 를 넘어 에이전트형 AI, 즉 자율 추론, 계획, 실행이 가능한 시스템으로 진화하고 있습니다. 이 과정에서 o11y는 모니터링을 넘어서 스스로 학습하는 메타지능의 핵심 인프라가 됩니다. 결국, 단순한 o11y를 넘어서 AI Agent가 스스로 진화하는 패러다임, 즉 지속 개선되는 '지속 학습형 Agent 서비스' 로의 전환에 핵심이 되는 것이 바로 o11y라고 생각합니다.

Mellerikat o11y의 자세한 사항은 링크를 참고하세요.

Mellerikat o11y Architecture