이미지에서 언어로, 언어에서 판단으로: 카메라 컨텍스트로 VLM 성능 끌어올리기

캠퍼스, 안전을 넘어 지능을 갖다: EVA와 함께하는 Postech Living Lab 프로젝트로 손민준 군(지도 교수 고영명 님)과 협동 연구한 주제입니다.

사용자의 한 줄 질의를 더 똑똑하게: 이미지 컨텍스트로 언어를 보강하는 법

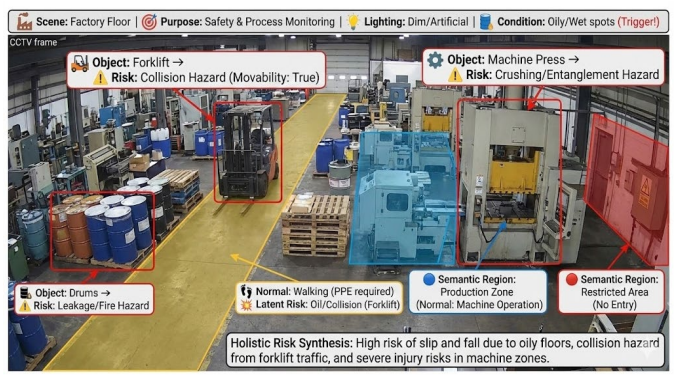

EVA는 수백~수천 대의 스마트 카메라로 이상 상황을 감지하는 시스템입니다. 우리는 VLM/LLM을 활용해 카메라 컨텍스트를 자동으로 추론하고, 이를 프롬프트에 녹여 넣어 탐지하고자 하는 이미지의 상황이 반영된(camera-context; 카메라 컨텍스트 기반) 이상 탐지 파이프라인을 만들었습니다. 단일 프레임으로 추출한 카메라 컨텍스트를 VLLM의 사전 지식으로 활용했을 때, 기존 베이스라인 대비 의미 있는 정확도 향상과 더 깊은 해석 가능성을 확인했습니다.

1. 왜 “컨텍스트 블라인드(Context-Blind)”가 문제인가

EVA가 다루는 카메라 환경은 사무실, 출입구, 주차장, 공사장, 복도 등 매우 다양하며, 각 카메라는 고유의 감시 목적을 가지고 있습니다. 그러나 대부분의 기존 Video Anomaly Detection (VAD) 시스템은 이러한 환경적, 목적적 차이를 무시하고 영상을 분석하는 근본적인 한계를 지닙니다.

-

모션에만 기반한 판단의 한계: "복도에서 뛰는 사람"과 "운동장에서 뛰는 사람"은 움직임 자체는 같지만, 보안 관점에서는 그 의미가 완전히 다릅니다. 컨텍스트가 없는 경우, 모션 정보만으로는 둘 다 '이상' 혹은 둘 다 '정상'으로 오인될 가능성이 높습니다.

-

도메인 지식의 부재: 범용 VLM/VLLM은 일반적인 지식은 풍부하지만, 보안 및 감시 도메인에 특화된 전문 지식이 부족하여 중요한 상황에서 모호하거나 부정확한 설명, 심지어 환각(Hallucination)을 생성하기 쉽습니다.

이러한 문제들은 결과적으로 높은 오탐률(High False Alarm) 을 유발하여, 시스템 운영자에게 알람 피로(Alert Fatigue)를 가중시키는 결과를 초래합니다.

2. EVA가 던진 핵심 질문과 접근 방식

우리의 연구는 다음의 핵심 질문에서 출발했습니다.

“컨텍스트 정보가 전혀 주어지지 않은 수천 대의 카메라에 대해, 영상만 보고 ‘이 카메라가 어디를, 무엇을, 어떤 목적으로 비추고 있는지’를 자동으로 추론할 수 없을까?”

이 질문을 실현하기 위해 다음과 같은 세 가지 주요 목표를 설정하고 파이프라인을 설계했습니다.

-

카메라 컨텍스트의 자동 추론: 이미지에 담긴 시점(Context), 목적(Purpose), 주요 객체(Object), 활동(Activity) 등과 같은 고차원 정보를 비디오 프레임으로부터 자동으로 추출하는 방법론을 개발했습니다.

-

LLM/VLM 프롬프트에 최적화된 표현 찾기: 추출된 컨텍스트를 JSON 형태, 요약 문장 형태 등 다양한 방식으로 인공지능 모델에 제공했을 때, 성능, 비용, 응답 시간 측면에서 가장 효율적인 표현 방식을 실험하고 분석했습니다.

-

컨텍스트 활용 파이프라인 설계: 단순히 객체 탐지 수준을 넘어서, 이미지 속 컨텍스트를 활용하여 이상 여부를 판단하는 Detection + Exception Logic 기반의 통합 파이프라인을 설계하는 데 중점을 두었습니다.

3. 카메라 컨텍스트란 무엇인가?

산학 협력 초기 미팅을 통해, 우리는 카메라 컨텍스트(Camera Context) 를 단순한 메타데이터가 아닌, 탐지 로직을 보정하고 강화하는 지식의 형태로 구체화했습니다.

핵심 컨텍스트 요소:

- 위치(Location): 주차장, 출입구, 공사장, 복도, 실외 운동장 등 장면의 유형.

- 카메라 방향·각도: 출입구를 정면으로 보는지, 높은 곳에서 내려다보는지 등 시점 정보.

- 조도·환경 요소: 실내/실외 구분, 조명 상태, 그림자 방향 등 물리적 환경.

- 주요 객체/행위 가정: 예: 공사장 컨텍스트라면 “사람은 기본적으로 헬멧을 착용하고 있다”는 가정이 이상 탐지 단계에 반영되어야 함.

이러한 컨텍스트는 탐지 자체(Detection)를 넘어, 예외 로직(Exception Logic) 을 구성하는 핵심 요소로 사용됩니다. 예외 로직은 탐지 결과와 컨텍스트를 결합하여 "이상 상황인지 아닌지"를 최종적으로 판단하는 규칙을 의미합니다.

초기에는 컨텍스트를 JSON 형태로 구조화하여 LLM/VLM에 전달했으며, 다양한 실험을 통해 카메라 컨텍스트를 요약 문장(String Summary)으로 입력하는 것보다 아래와 같은 정형화된 JSON 형태로 전달했을 때 이상 탐지 성능이 더 우수하다는 점을 확인했습니다.

{

"camera_id": "C1234",

"location_type": "indoor",

"view_focus": "entrance_gate",

"main_object": ["person", "bag"],

"purpose": "access control",

"activity": "entry/exit monitoring"

}

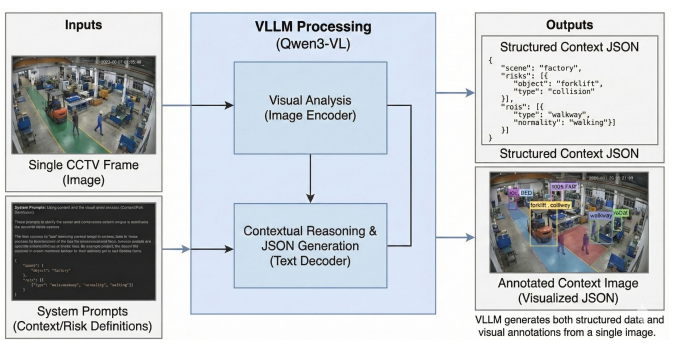

4. Single-Frame Context: 전체 영상을 한 장으로 요약하기

전체 비디오 클립을 매번 VLM에 입력하는 것은 비용 효율성과 지연 시간 측면에서 현실적인 운영 방안이 아닙니다. 따라서 우리는 대표성이 높은 단일 프레임(Single-Frame) 을 활용하여 핵심 컨텍스트를 추출하는 데 집중했습니다.

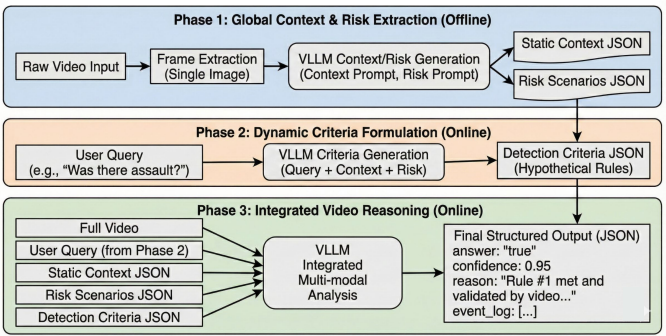

세 단계로 나눈 파이프라인 설계

저희는 더 고품질의 심층적 컨텍스트를 추출하고 이를 이상 탐지에 활용하기 위해, 전체 프로세스를 세 단계로 구분하여 파이프라인을 설계했습니다.

-

Offline Context Extraction (정적 컨텍스트 추출):

- 배경이 잘 드러나는 대표 프레임을 선정합니다.

- VLM(예: Qwen3-VL-8B-Instruct)을 사용하여 장면 타입 (Factory floor, Hallway 등), 잠재 위험요소(Risk Scenarios), 주요 객체 및 레이아웃을 분석�합니다.

- 이 정보를 인공지능이 잘 이해할 수 있는 정형 형식(JSON)의 텍스트로 생성하여 사전 지식(Static Context) 으로 저장합니다.

-

Online Criteria Formulation (온라인 기준 생성):

- 사용자가 정의한 이상 탐지 질의(User Query) 와 사전에 추출된 정적 컨텍스트를 조합합니다.

- 이를 통해 “어떤 행동을 이상으로 간주할 것인가?”에 대한 구체적인 룰 기반 기준(Criteria) 을 VLLM이 자동으로 생성하게 합니다. 예: “이 공장 환경에서는 작업자가 안전모 없이 기계 근처에 10초 이상 머무르는 경우 위험으로 간주한다.”

-

Integrated Video Reasoning (통합 추론):

- 실제 분석 대상인 비디오 클립과 사용자 질의, 그리고 Static Context 및 Generated Criteria를 함께 VLLM에 최종 입력합니다.

- VLLM은 이 모든 문맥 정보를 바탕으로 이상 여부를 판단하며, “지금 이 프레임에서 왜 이 행동을 위험하다고 판단했는지”를 설명하는 (Explainable) 결과를 출력합니다.

이러한 구조 덕분에 영상 전체를 매번 분석하는 대신, 한 번 추출해 놓은 컨텍스트를 재사용하면서도, 문맥을 이해하는 심층적인 추론을 수행할 수 있게 되었습니다.

5. 무엇이 실제로 좋아졌나?

실제 데이터셋(UCF Crime, AI Hub 등)을 활용한 실험 및 분석 결과는 컨텍스트 기반 접근의 유효성을 명확하게 입증했습니다.

-

정확도의 유의미한 향상: 정적 컨텍스트를 사전 지식으로 VLLM에 제공했을 때, 이상 탐지 정확도가 유의미하게 개선되었습니다. 특히, 특정 환경에서만 의미가 있는 행동(예: 공사장 안전모 미착용, 출입구 주변의 체류 등)에 대한 탐지 성능이 크게 개선되었습니다.

-

해석 가능성의 극대화: 모델이 단순한 이상 감지를 넘어, “왜 이 장면을 위험하다고 보는지”를 카메라의 위치/목적, 잠재 위험요소, 사용자가 등록한 탐지 시나리오 등에 근거하여 서술해 줍니다. 이는 운영자가 알람의 신뢰도를 빠르게 판단하는 데 결정적인 도움을 줍니다.

-

False Alarm 감소 가능성: 동일한 "달리기" 행동이라도, 운동장 컨텍스트에서는 정상으로, 실내 복도 컨텍스트에서는 이상으로 정확히 구분할 수 있게 되었습니다. 이는 오탐률을 낮추고 운영자의 알람 피로도를 줄이는 데 직접적으로 기여합니다.

-

파이프라인 설계의 중요성 확인: 단일 환경에 최적화된 분류 모델을 만드는 것보다, 다양한 환경에 유연하게 적용될 수 있는 컨텍스트 기반의 탐지 파이프라인 설계가 실제 서비스 운영 측면에서 훨씬 더 중요함을 확인했습니다.

6. 앞으로의 로드맵

이번 연구는 컨텍스트 추출��을 시작으로, Knowledge Internalization (지식 내재화) 로 확장하는 로드맵의 시작점입니다.

향후 다음과 같은 방향으로 연구와 개발을 지속할 예정입니다.

-

컨텍스트 항목 및 표현 고도화: 카메라 유형, 설치 목적, 감지 시나리오에 따라 어떤 컨텍스트 항목이 성능에 가장 중요한지 심층적으로 분석하고, JSON과 자연어 요약을 혼합한 하이브리드 컨텍스트 표현 방식을 실험할 계획입니다.

-

Adaptive VLLM 프레임워크 구축: 상황과 질의의 복잡도에 따라 서로 다른 VLM/LLM 조합과 프롬프트 템플릿을 자동으로 선택하는 Adaptive 프레임워크를 LangGraph 기반으로 설계하여 EVA 에이전트 API 형태로 제공할 예정입니다.

-

대규모 운영 검증: EVA 실제 서비스 환경에 이 파이프라인을 적용하여, 컨텍스트 유무에 따른 알람 감소율, 오탐/미탐 비율, 운영자 피드백 등을 포함하는 종합적인 운영 지표를 검증할 것입니다.

-

보안 도메인 지식 내재화: 반복되는 이상 탐지 시나리오와 운영 피드백을 기반으로 “EVA 전용 보안 도메인 지식”을 점진적으로 축적하고, 이를 VLLM의 초기 프롬프트 또는 어댑터 형태로 반영하여 모델 자체의 지능을 높이는 방향을 검토할 것입니다.

7. 맺으며

이번 산학 연구는 "VLM이 '무엇이 보이는지'만 말하는 것이 아니라, '왜 이 장면이 지금 이 카메라에서는 중요한지'를 말하게 만들 수 없을까?"라는 질문에 대한 실질적인 답을 찾는 과정이었습니다.

우리는 Single-Frame Scene Knowledge를 기반으로 한 Camera Context-Aware VAD 파이프라인을 제안했고, 이를 통해 실제 환경에서 의미 있는 성능과 해석력 향상이라는 가능성을 확인했습니다.

컨텍스트 없는 영상 분석은 결국 "문맥 없는 단어 읽기"에 불과합니다. 단 한 장의 대표 프레임에서 시작된 컨텍스트 추출이 VLLM의 시선을 **"사용자가 진짜 궁금해하는 곳"**으로 명확하게 이끌 수 있음을 입증한 것입니다.